선형대수학, 그 열 번째 이야기 | 선형 변환(Linear Transformation)

선형 변환이란 두 벡터 공간 사이를 오가는 말 그대로 변환이다. 이는 앞으로 여러 벡터 공간 사이의 관계를 파악하는데 중요한 역할을 한다.

선형 변환은 아래와 같이 정의한다.

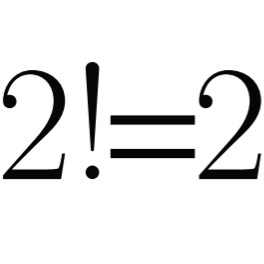

$V$ 와 $W$ 가 체 $F$ 위의 벡터 공간이라고 하자. 함수 $T : V \rightarrow W$ 가 선형변환이려면 모든 $x, y \in V$ 와 $c \in F$ 에 대해 1. $T(x + y) = T(x) + T(y)$ 2. $T(cx) = cT(x)$ 를 만족해야 한다. 이를 $V$ 에서 $W$ 로 가는 선형변환이라고 부른다. |

만약 $F$ 가 유리수체라면, 위의 두 조건은 서로 같은 조건이다. 그러나 일반적으로 둘은 완전히 다르다.

$T$ 가 $V$ 에서 $W$ 로 가는 선형 변환일 때, 이를 $T$ 는 선형이라고 말하기도 한다.

어떤 특수한 선형 변환은 이름을 따로 붙여가며 자주 언급된다. 그렇기에 여기에서도 두 가지를 소개하겠다.

체 $F$ 위의 벡터 공간 $V$ 와 $W$ 에 대해, $I_V$ 와 $T_0$ 는 다음과 같이 정의된다. $I_V : V \rightarrow V$ 이고 $I_V(x) = x$ 가 모든 $x \in V$ 에 대해 성립한다. $T_0 : V \rightarrow W$ 이고 $T_0(x) = 0$ 이 모든 $x \in V$ 에 대해 성립한다. |

두 함수가 선형임은 자명하므로 증명은 생략하겠다. 이 때, $I_V$ 를 항등변환(identity transformation) 이라 하고 $T_0$ 를 영변환(zero transformation) 이라고 한다. 또 정의역이 분명한 경우 $I_V$ 대신 $I$ 라고 쓰기도 한다.

이제 선형 변환에 관한 두 가지 매우 중요한 집합에 대해 정의하자.

$V$ 와 $W$ 가 벡터 공간이고, $T : V \rightarrow W$ 가 선형 변환이라고 하자. 이 때 $T$ 의 null space(혹은 kernal) $N(T)$ 와 range(혹은 image) $R(T)$ 는 다음과 같이 정의한다. $N(T) = \{ x \in V : T(x) = 0\}$, $R(T) = \{ T(x) : x \in V\}$ |

이 때, $N(T)$ 와 $R(T)$ 에 대해 다음과 같은 정리가 성립한다.

$V$ 와 $W$ 가 $F$ 위의 벡터 공간이고 $T : V \rightarrow W$ 가 선형 변환이라고 하자. $N(T)$ 와 $R(T)$ 는 각각 $V$ 와 $W$ 의 부분 공간이다. |

Proof

우선, $V$ 와 $W$ 의 영벡터를 각각 $0_V$ 와 $0_W$ 로 표기하자.

$$T(0_V + 0_V) = T(0_V) = T(0_V) + T(0_V) \Rightarrow T(0_V) = 0_W$$ 이므로, $0_V \in N(T)$ 이다.

이제 $x, y \in N(T)$ 와 $c \in F$ 를 생각하자. $$T(x + y) = T(x) + T(y) = 0_W + 0_W = 0_W \\ T(cx) = cT(x) = c0_W = 0_W$$ 이므로 $x + y \in N(T)$ 이고 $cx \in N(T)$ 이다. 따라서 $N(T)$ 는 $V$ 의 부분 공간이다.

또한 $T(0_V) = 0_W$ 이므로 $0_W \in R(T)$ 이다.

이제 $x, y \in R(T)$ 와 $c \in F$ 를 생각하자. $T(v) = x, T(w) = y$ 인 $v, w \in V$ 가 존재하므로 $$T(v + w) = T(v) + T(w) = x + y\\ T(cv)= cT(v) = cx$$ 이므로 $x + y \in R(T)$ 이고 $cx \in R(T)$ 이다. 따라서 $R(T)$ 는 $W$ 의 부분 공간이다.

두 벡터 공간 사이에 선형 변환이 존재한다면, 그 기저 사이에서도 관계를 찾을 수 있다. 아래의 정리를 보자.

$V$ 와 $W$ 가 $F$ 위의 벡터 공간이고, $T : V \rightarrow W$ 가 선형이라고 하자. 만약 $\beta = \{v_1, v_2, \cdots, v_n \}$ 이 $V$ 의 기저라면, $R(T) = \mathrm{span}(T(\beta)) = \mathrm{span}(\{T(v_1), T(v_2), \cdots, T(v_n)\})$ 이다. |

Proof

우선 $T(v_i) \in R(T)$ 가 $i = 1, 2, \cdots, n$ 에 대해 참임은 정의에 의해 자명하다. $R(T)$ 는 위의 정리에 의해 $W$ 의 부분 공간이므로, $$(\{T(v_1), T(v_2), \cdots, T(v_n)\}) = \mathrm{span}(T(\beta)) \subseteq R(T)$$ 임이 이 글의 첫번째 정리에 의해 보장된다.

이제 임의의 $w \in R(T)$ 를 잡자. 정의에 의해 $w = T(v)$ 인 $v \in V$ 가 존재한다. 그런데 $\beta$ 는 $V$ 의 기저이므로 어떤 $a_1, a_2, \cdots, a_n \in F$ 에 대해 $$v = a_1 v_1 + a_2 v_2 + \cdots + a_n v_n$$ 이 성립한다. $T$ 는 선형이므로, $$w = T(v) = T(a_1 v_1 + a_2 v_2 + \cdots + a_n v_n) = a_1 T(v_1) + a_2 T(v_2) + \cdots + a_n T(v_n)$$ 이다. 이는 $w \in \mathrm{span}(\beta)$ 임을 의미한다.

따라서 $R(T) = \mathrm{span}(\beta) = \mathrm{span}(\{T(v_1), T(v_2), \cdots, T(v_n)\})$ 이다.

위의 정리에서는, 자연스럽게 $\beta$ 를 유한집합으로 설정하여 $V$ 가 유한 차원 벡터 공간일때만을 다뤘으나, 이는 무한 차원일때도 성립한다. 이를 증명해보자.

Proof

$\mathrm{span}(\{T(v) : v\in \beta\}) \subseteq R(T)$ 임은 $R(T)$ 의 정의에 의해 자명하다. 이제 임의의 $y \in R(T)$ 를 잡으면, 어떤 $x \in V$ 에 대해 $T(x) = y$ 가 성립한다. 그런데 $x$ 는 $V$ 의 원소이므로 그 기저에 포함된 유한한 개수의 벡터의 선형결합으로 표시될 수 있다. (무한히 많은 벡터를 기저로 가지더라도 선형 결합은 그 중 유한 개를 선택해서 진행된다) 따라서 $$ x = \sum_{i=1}^{k} a_i v_i $$ 인 $v_1, v_2, \cdots, v_k \in \beta$ 와 $a_1, a_2, \cdots, a_k \in F$ 가 존재한다. 그러므로 $$ y = T(x) = T(\sum_{i=1}^{k} a_i v_i ) = \sum_{i=1}^{k} a_i T(v_i)$$ 가 되어, $y \in \mathrm{span}(\{T(v) : v\in \beta\})$ 가 된다. 따라서 $R(T) = \mathrm{span}(T(\beta))$ 이다.

'수학 > 선형대수학 | Linear Algebra' 카테고리의 다른 글

| 선형대수학, 그 열두 번째 이야기 | 선형 변환의 성질 (0) | 2021.02.02 |

|---|---|

| 선형대수학, 그 열한 번째 이야기 | Dimension Theorem (0) | 2021.02.02 |

| 선형대수학, 그 아홉 번째 이야기 | 무한 차원 벡터 공간 (0) | 2021.02.02 |

| 선형대수학, 그 여덟 번째 이야기 | 벡터 공간의 차원(Dimension) (0) | 2021.02.01 |

| 선형대수학, 그 일곱 번째 이야기 | Replacement Theorem (2) | 2021.02.01 |